Netzwerkstrukturen-mit-InfiniBand: Unterschied zwischen den Versionen

Ansp (Diskussion | Beiträge) (Die Seite wurde neu angelegt: „=== ''' Netzwerkstrukturen mit InfiniBand ''' === === ''' Zukunftssicher und mittelstandstauglich ''' === ''' Die Entwicklung der Basistechnologien und Übertr…“) |

Deko (Diskussion | Beiträge) (→Weitere Informationen) |

||

| (23 dazwischenliegende Versionen von 5 Benutzern werden nicht angezeigt) | |||

| Zeile 1: | Zeile 1: | ||

| − | |||

=== ''' Zukunftssicher und mittelstandstauglich ''' === | === ''' Zukunftssicher und mittelstandstauglich ''' === | ||

''' Die Entwicklung der Basistechnologien und Übertragungsraten im Netzwerk- und Storagebereich ist in den letzten Jahren weit hinter dem Wachstum von Datenvolumen und Rechenkapazitäten in allen Anwendungsszenarien zurückgeblieben. Umso dringlicher wird die Suche nach zukunftsfähigen Al-ternativen auch im Mittelstand. InfiniBand verspricht, dafür die Lösung zu sein. ''' <br /> | ''' Die Entwicklung der Basistechnologien und Übertragungsraten im Netzwerk- und Storagebereich ist in den letzten Jahren weit hinter dem Wachstum von Datenvolumen und Rechenkapazitäten in allen Anwendungsszenarien zurückgeblieben. Umso dringlicher wird die Suche nach zukunftsfähigen Al-ternativen auch im Mittelstand. InfiniBand verspricht, dafür die Lösung zu sein. ''' <br /> | ||

<br /> | <br /> | ||

| − | Welcher IT-Verantwortliche hätte sich das nicht auch schon gewünscht? Eine neue, stabile Technologie für den Serverpark, mit der die Übertragung großer Datenmengen nicht zur Geduldsprobe ausartet und die gleichzeitig weder das Budget noch die beherrschbare Komplexität sprengt. Noch weitgehend unbemerkt von der durchschnittlichen IT-Organisation hat sich in jüngster Zeit die InfiniBand-Technologie (IB) zu einer Lösung dieser Fragen gemausert. Sie verspricht, alle gewünschten Eigenschaften in sich zu vereinen, bis auf eine: Sie ist nicht neu. Das muss aber kein Nachteil sein. | + | Welcher IT-Verantwortliche hätte sich das nicht auch schon gewünscht? Eine neue, stabile Technologie für den Serverpark, mit der die Übertragung großer Datenmengen nicht zur Geduldsprobe ausartet und die gleichzeitig weder das Budget noch die beherrschbare Komplexität sprengt. Noch weitgehend unbemerkt von der durchschnittlichen IT-Organisation hat sich in jüngster Zeit die InfiniBand-Technologie (IB) zu einer Lösung dieser Fragen gemausert. Sie verspricht, alle gewünschten Eigenschaften in sich zu vereinen, bis auf eine: Sie ist nicht neu. Das muss aber kein Nachteil sein. |

| + | |||

=== ''' Historie ''' === | === ''' Historie ''' === | ||

| − | Tatsächlich wurde der erste InfiniBand-Standard bereits im Jahr 2000 verabschiedet von der InfiniBand Trade Association (ITBA, ein Zusammenschluss von Compaq, Dell, Hewlett-Packard, IBM, Intel, Microsoft und Sun). Er war damals gedacht als Nachfolgetechnologie für den PCI Bus. Nachdem sich aber im Segment der Arbeitsstationen und Enterprise-Server stattdessen der PCI Express als Bus-System durchgesetzt hat, wurde InfiniBand immer mehr eine Verbindungstechnologie in der Domäne von Supercomputern und High-Performance-Anwendungen. Im Jahr 2014 basierten 45% der in der TOP500 gelisteten Supercomputer auf InfiniBand. Das zeigt, dass InfiniBand eine höchst ausgereifte, stabile und skalierbare Technologie ist, die jedoch lange Zeit zu teuer für den Einsatz in normalen Unternehmen war. Dies hat sich zuletzt deutlich ver-ändert: Aufgrund technologischer Innovationen und der Suche nach neuen Zielmärkten sind die Preise für InfiniBand-Komponenten in den letzten Jahren auf ein Niveau gesunken, das sich nicht mehr von dem der Konkurrenztechnologien wie 10 GBit Ethernet oder Fibre Channel unterscheidet. | + | Tatsächlich wurde der erste InfiniBand-Standard bereits im Jahr 2000 verabschiedet von der InfiniBand Trade Association (ITBA, ein Zusammenschluss von Compaq, Dell, Hewlett-Packard, IBM, Intel, Microsoft und Sun). Er war damals gedacht als Nachfolgetechnologie für den PCI Bus. Nachdem sich aber im Segment der Arbeitsstationen und Enterprise-Server stattdessen der PCI Express als Bus-System durchgesetzt hat, wurde InfiniBand immer mehr eine Verbindungstechnologie in der Domäne von Supercomputern und High-Performance-Anwendungen. Im Jahr 2014 basierten 45% der in der TOP500 gelisteten Supercomputer auf InfiniBand. Das zeigt, dass InfiniBand eine höchst ausgereifte, stabile und skalierbare Technologie ist, die jedoch lange Zeit zu teuer für den Einsatz in normalen Unternehmen war. Dies hat sich zuletzt deutlich ver-ändert:<br /> |

| + | Aufgrund technologischer Innovationen und der Suche nach neuen Zielmärkten sind die Preise für InfiniBand-Komponenten in den letzten Jahren auf ein Niveau gesunken, das sich nicht mehr von dem der Konkurrenztechnologien wie 10 GBit Ethernet oder Fibre Channel unterscheidet. | ||

| + | |||

=== ''' Technologie ''' === | === ''' Technologie ''' === | ||

Obwohl ähnlich im Preisgefüge besitzt die Technologie von InfiniBand doch im Kern eine völlig andere Archi-tektur. Es handelt sich nicht um eine Netzwerk- sondern um eine Busstruktur. Man kann sich InfiniBand als eine „Verlängerung“ des serverinternen PCIe Busses vorstellen. Damit einher gehen einige Merkmale, die wesentlich für das Performanceversprechen dieses Standards sind: Die Übertragungsrate beträgt derzeit bis zu 100 GBit/s je Port bei gleichzeitig extrem niedriger Latenz. Für höhere Performanceanforderungen können mehrere physikalische Ports logisch gekoppelt werden. Als etablierte, nicht-experimentelle Technologie steht InfiniBand derzeit 10 GBit Ethernet bzw. 8 bis 16 GBit Fibre Channel gegenüber. Bei Storage-Anwendungen überträgt IB die Daten per RDMA (Remote Direct Memory Access). Dieses Feature erlaubt es Anwendungen, Daten direkt in den Hauptspeicher des Zielsystems zu schreiben, ohne Umweg über einen Netzwerkprotokoll-Stack. Das entlastet die CPU und vermeidet unnötige und zeitintensive Kopiervorgänge. Dieselbe Systematik ist mit InfiniBand auch für paketorientierte Netzwerkanwendungen verfügbar und wird RoCE genannt (RDMA over Converged Ethernet). Gleichzeitig gliedert sich InfiniBand nahtlos in bestehende IT-Landschaften ein, denn den Anwendungen zeigt es sich in der tatsächlichen Nutzung je nach Konfiguration als Netz- oder Datenverbindung. Diese Einstellung ist durch den Administrator festlegbar und hängt nicht von der eingesetzten IB Hardware ab. Anders ausgedrückt: Mit ein und derselben InfiniBand-Hardware lassen sich flexibel mehrere parallel nutzbare Ethernet- und blockbasierte Verbindungen (SRP/iSER) mit defi-nierbaren Bandbreiten realisieren. Die Einrichtung der IB-Komponenten ist kein Hexenwerk, sollte aber in Hinsicht auf die gewünschte Gesamtstruktur in Produktivumgebungen nur von Experten mit InfiniBand-Erfahrung durchgeführt werden. V.a. in heterogenen Systemlandschaften mit gemischten Technologien und unterschiedlichen Betriebssystemen gibt es bei der Umsetzung diverse Fallstricke, die erkannt und umgan-gen werden wollen. Im laufenden Betrieb unterstützt InfiniBand den Administrator dann durch seine umfang-reichen Monitoring-Fähigkeiten, die deutlich über das von der Konkurrenz Gewohnte hinausgehen. Spätes-tens hier jedoch stößt der Einsteiger an seine Grenzen, denn Konfiguration und treffsichere Interpretation des InfiniBand-Monitorings erfordern einiges an Detail-Know-How.<br /> | Obwohl ähnlich im Preisgefüge besitzt die Technologie von InfiniBand doch im Kern eine völlig andere Archi-tektur. Es handelt sich nicht um eine Netzwerk- sondern um eine Busstruktur. Man kann sich InfiniBand als eine „Verlängerung“ des serverinternen PCIe Busses vorstellen. Damit einher gehen einige Merkmale, die wesentlich für das Performanceversprechen dieses Standards sind: Die Übertragungsrate beträgt derzeit bis zu 100 GBit/s je Port bei gleichzeitig extrem niedriger Latenz. Für höhere Performanceanforderungen können mehrere physikalische Ports logisch gekoppelt werden. Als etablierte, nicht-experimentelle Technologie steht InfiniBand derzeit 10 GBit Ethernet bzw. 8 bis 16 GBit Fibre Channel gegenüber. Bei Storage-Anwendungen überträgt IB die Daten per RDMA (Remote Direct Memory Access). Dieses Feature erlaubt es Anwendungen, Daten direkt in den Hauptspeicher des Zielsystems zu schreiben, ohne Umweg über einen Netzwerkprotokoll-Stack. Das entlastet die CPU und vermeidet unnötige und zeitintensive Kopiervorgänge. Dieselbe Systematik ist mit InfiniBand auch für paketorientierte Netzwerkanwendungen verfügbar und wird RoCE genannt (RDMA over Converged Ethernet). Gleichzeitig gliedert sich InfiniBand nahtlos in bestehende IT-Landschaften ein, denn den Anwendungen zeigt es sich in der tatsächlichen Nutzung je nach Konfiguration als Netz- oder Datenverbindung. Diese Einstellung ist durch den Administrator festlegbar und hängt nicht von der eingesetzten IB Hardware ab. Anders ausgedrückt: Mit ein und derselben InfiniBand-Hardware lassen sich flexibel mehrere parallel nutzbare Ethernet- und blockbasierte Verbindungen (SRP/iSER) mit defi-nierbaren Bandbreiten realisieren. Die Einrichtung der IB-Komponenten ist kein Hexenwerk, sollte aber in Hinsicht auf die gewünschte Gesamtstruktur in Produktivumgebungen nur von Experten mit InfiniBand-Erfahrung durchgeführt werden. V.a. in heterogenen Systemlandschaften mit gemischten Technologien und unterschiedlichen Betriebssystemen gibt es bei der Umsetzung diverse Fallstricke, die erkannt und umgan-gen werden wollen. Im laufenden Betrieb unterstützt InfiniBand den Administrator dann durch seine umfang-reichen Monitoring-Fähigkeiten, die deutlich über das von der Konkurrenz Gewohnte hinausgehen. Spätes-tens hier jedoch stößt der Einsteiger an seine Grenzen, denn Konfiguration und treffsichere Interpretation des InfiniBand-Monitorings erfordern einiges an Detail-Know-How.<br /> | ||

| + | |||

| + | [[Datei: Performance.jpg|left|thumb|400px]] | ||

| + | <br /><br /><br /><br /><br /><br /><br /><br /><br /><br /><br /><br /><br /><br /><br /><br /><br /><br /><br /> | ||

| + | ''InfiniBand bietet überlegene Bandbreiten für die Vernetzung von Servern und Rechenzentren. Die Preise der drei Technologien bewegen sich auf vergleichbarem Niveau.'' | ||

| + | <br /> | ||

| + | |||

=== ''' Komponenten und Anbieter ''' === | === ''' Komponenten und Anbieter ''' === | ||

| − | InfiniBand stellt den derzeit einzigen nicht-proprietären offenen Hochgeschwindigkeitsstandard dar. Eine InfiniBand-Infrastruktur wird aus denselben grundlegenden Komponenten aufgebaut wie herkömmliche Net-ze: IB-Host-Channel-Adapter (HCAs) in den beteiligten Servern, dazwischen IB-Kabel aus Kupfer oder Glas-faser und im Allgemeinen auch IB-Switches bzw. Router. Preise beginnen bei unter 500,- Euro für HCAs, unter 3.500,- Euro für einen 12-Port Managed Switch und unter 100,- Euro für 5 Meter Kupferkabel. Viele IB-Switches bieten eine Besonderheit: Damit die schöne neue InfiniBand-Welt keine Insel bleibt, besitzen sie die Möglichkeit über ein Splitter-Kabel einen 40G-Port in einen oder mehrere 10G-Ports für den Übergang ins restliche Unternehmensnetzwerk bereitzustellen. Mit einem 12-Port Switch sind so 48x10G-Ports realisierbar. Trotz gesunkener Preise wird kaum eine Organisation mehr als den Serverraum mit InfiniBand ausstatten wollen, obwohl das technisch in einer geswitchten Infrastruktur mit Kabellängen von bis zu über hundert Metern durchaus möglich wäre. Zum Betrieb der HCAs in den Servern bedarf es passender Treiber je Betriebssystem. Aufgrund der Offenheit und Unabhängigkeit des Standards sind diese für alle gängigen Systeme verfügbar, u.a. für Windows Server und Client Versionen, alle großen Linux Distributionen wie Red Hat und SUSE sowie für die Virtualisierer VMware ESXi, Microsoft Hyper-V und Citrix/Xen. Der dominieren-de Hersteller von IB-Baugruppen ist die Firma Mellanox, die auch alle Varianten von fertigen Komponenten anbietet. Komponenten stellen aber auch diverse andere Integratoren her, wie beispielsweise Intel/QLogic oder Oracle/Sun. Auch weitere Major Brands setzen mit ihren Produkten auf InfiniBand, etwa Cisco bei Ser-ver¬switches der 3000er und 7000er Serie. Andere Anbieter tun innerhalb ihrer Black-Boxen dasselbe, aller-dings ohne dabei InfiniBand beim Namen zu nennen. Trotz der Offenheit des Standards ist aber nicht zu leugnen, dass die Schar der Anbieter von InfiniBand-Komponenten derzeit noch überschaubar ist. Das liegt an der Abgeschlossenheit des High Performance Computing Bereichs, in dem sich InfiniBand bis vor weni-gen Jahren ausschließlich entwickelt hat. Es steht zu erwarten, dass mit den gesunkenen Preisen und wachsender Verbreitung auch die Anbieter in absehbarer Zeit deutlich zahlreicher werden.<br /> | + | InfiniBand stellt den derzeit einzigen nicht-proprietären offenen Hochgeschwindigkeitsstandard dar. Eine InfiniBand-Infrastruktur wird aus denselben grundlegenden Komponenten aufgebaut wie herkömmliche Net-ze: IB-Host-Channel-Adapter (HCAs) in den beteiligten Servern, dazwischen IB-Kabel aus Kupfer oder Glas-faser und im Allgemeinen auch IB-Switches bzw. Router. Preise beginnen bei unter 500,- Euro für HCAs, unter 3.500,- Euro für einen 12-Port Managed Switch und unter 100,- Euro für 5 Meter Kupferkabel. Viele IB-Switches bieten eine Besonderheit:<br /> |

| + | Damit die schöne neue InfiniBand-Welt keine Insel bleibt, besitzen sie die Möglichkeit über ein Splitter-Kabel einen 40G-Port in einen oder mehrere 10G-Ports für den Übergang ins restliche Unternehmensnetzwerk bereitzustellen. Mit einem 12-Port Switch sind so 48x10G-Ports realisierbar. Trotz gesunkener Preise wird kaum eine Organisation mehr als den Serverraum mit InfiniBand ausstatten wollen, obwohl das technisch in einer geswitchten Infrastruktur mit Kabellängen von bis zu über hundert Metern durchaus möglich wäre. Zum Betrieb der HCAs in den Servern bedarf es passender Treiber je Betriebssystem. Aufgrund der Offenheit und Unabhängigkeit des Standards sind diese für alle gängigen Systeme verfügbar, u.a. für Windows Server und Client Versionen, alle großen Linux Distributionen wie Red Hat und SUSE sowie für die Virtualisierer VMware ESXi, Microsoft Hyper-V und Citrix/Xen. Der dominieren-de Hersteller von IB-Baugruppen ist die Firma Mellanox, die auch alle Varianten von fertigen Komponenten anbietet. Komponenten stellen aber auch diverse andere Integratoren her, wie beispielsweise Intel/QLogic oder Oracle/Sun. Auch weitere Major Brands setzen mit ihren Produkten auf InfiniBand, etwa Cisco bei Ser-ver¬switches der 3000er und 7000er Serie. Andere Anbieter tun innerhalb ihrer Black-Boxen dasselbe, aller-dings ohne dabei InfiniBand beim Namen zu nennen. Trotz der Offenheit des Standards ist aber nicht zu leugnen, dass die Schar der Anbieter von InfiniBand-Komponenten derzeit noch überschaubar ist. Das liegt an der Abgeschlossenheit des High Performance Computing Bereichs, in dem sich InfiniBand bis vor weni-gen Jahren ausschließlich entwickelt hat. Es steht zu erwarten, dass mit den gesunkenen Preisen und wachsender Verbreitung auch die Anbieter in absehbarer Zeit deutlich zahlreicher werden.<br /> | ||

| + | |||

| + | [[Datei: IB-Komponenten.JPG|left|thumb|400px]] | ||

| + | |||

| + | <br /><br /><br /><br /><br /><br /><br /><br /><br /><br /><br /><br /><br /><br /><br /><br /><br /><br /> | ||

| + | ''InfiniBand-Komponenten: Switch, Host-Channel-Adapter und Kabel'' <br /> | ||

| + | |||

=== ''' Vorteile und Einschränkungen ''' === | === ''' Vorteile und Einschränkungen ''' === | ||

| − | So ergeben sich im Vergleich zu herkömmlichen Verkabelungslösungen im Serverbereich eine ganze Reihe von Vorteilen: Neben deutlich höheren und skalierbaren Übertragungsbandbreiten bei gleichzeitig geringerer Latenz und Hostbelastung stellt InfiniBand durch die hohe Produktreife im Betrieb erstklassige Zuverlässig-keit und Wartbarkeit sicher. Die Möglichkeit, InfiniBand-Verbindungen bedarfsgerecht sowohl als Netzwerk-wie auch als Datenverbindung zu konfigurieren, birgt das Potential, sowohl Ethernet als auch Fibre Channel bzw. iSCSI bei der Serververnetzung nicht nur zu ergänzen, sondern vollständig abzulösen. Man spricht in diesem Zusammenhang von Netzwerkkonvergenz. Daraus wird in vielen Fällen nicht nur eine Leistungsstei-gerung resultieren, sondern gleichzeitig eine Komplexitätsreduktion der notwendigen Netzstrukturen. Zum einen sinkt aufgrund der Bandbreitenvorteile tendenziell die Anzahl der notwendigen physikalischen Verbin-dungen, zum anderen lassen sich alle Anwendungsfälle mit derselben Technologie abdecken. Das führt dazu, dass auch die Kosten für Aufbau und Betrieb eines IB-Netzes häufig niedriger ausfallen als bei den Konkurrenztechnologien: Eine geringere Anzahl an technischen Komponenten, weniger stark diversifiziertes Fachwissen innerhalb der Betriebsgruppen und zu guter Letzt die Herstellerunabhängigkeit und Offenheit des Standards mit entsprechend konkurrenzfähigen Komponenten- und Lizenzmodellen machen dies möglich.<br /> | + | So ergeben sich im Vergleich zu herkömmlichen Verkabelungslösungen im Serverbereich eine ganze Reihe von Vorteilen:<br /> |

| + | Neben deutlich höheren und skalierbaren Übertragungsbandbreiten bei gleichzeitig geringerer Latenz und Hostbelastung stellt InfiniBand durch die hohe Produktreife im Betrieb erstklassige Zuverlässig-keit und Wartbarkeit sicher. Die Möglichkeit, InfiniBand-Verbindungen bedarfsgerecht sowohl als Netzwerk-wie auch als Datenverbindung zu konfigurieren, birgt das Potential, sowohl Ethernet als auch Fibre Channel bzw. iSCSI bei der Serververnetzung nicht nur zu ergänzen, sondern vollständig abzulösen. Man spricht in diesem Zusammenhang von Netzwerkkonvergenz. Daraus wird in vielen Fällen nicht nur eine Leistungsstei-gerung resultieren, sondern gleichzeitig eine Komplexitätsreduktion der notwendigen Netzstrukturen. Zum einen sinkt aufgrund der Bandbreitenvorteile tendenziell die Anzahl der notwendigen physikalischen Verbin-dungen, zum anderen lassen sich alle Anwendungsfälle mit derselben Technologie abdecken. Das führt dazu, dass auch die Kosten für Aufbau und Betrieb eines IB-Netzes häufig niedriger ausfallen als bei den Konkurrenztechnologien: Eine geringere Anzahl an technischen Komponenten, weniger stark diversifiziertes Fachwissen innerhalb der Betriebsgruppen und zu guter Letzt die Herstellerunabhängigkeit und Offenheit des Standards mit entsprechend konkurrenzfähigen Komponenten- und Lizenzmodellen machen dies möglich.<br /> | ||

| + | |||

| + | Wo so viel Licht ist, muss es naturgemäß auch Schatten geben. So ist InfiniBand zum heutigen Stand klar auf die Vernetzung innerhalb von Serverräumen bzw. Rechenzentren ausgelegt. Gebäudeübergreifende (Campus) Netzwerke sind von 1-80km möglich. Für die Vernetzung hin zu den Clients ist Ethernet nach wie vor unersetzlich. Auch wenn der Übergang von den IB-Komponenten leicht gemacht wird, ist doch auch in Zukunft entsprechendes Ethernet-Equipment und Know-How für die IT-Organisationen unerlässlich. Und auch bei der Überbrückung weiter Entfernungen ist InfiniBand nicht immer erste Wahl:<br /> | ||

| + | Über Glasfaser lassen sich derzeit WAN-Strecken mit bis zu 1600 Kilometer überbrücken, die Reichweite von Ethernet bleibt jedoch unübertroffen.<br /> | ||

| + | |||

| + | [[Datei:Konsolidierung.jpg|left|thumb|400px]] | ||

| + | <br /><br /><br /><br /><br /><br /><br /><br /><br /><br /><br /><br /><br /><br /><br /><br /><br /> | ||

| + | |||

| + | ''Netzwerkkonvergenz: Da InfiniBand sowohl als Ethernet als auch als Fibre Channel Verbindungen konfiguriert werden können, lässt es sich leicht in bestehende Infrastrukturen integrieren und bietet die Möglichkeit, die alten Standards schrittweise vollständig abzulösen.'' | ||

| − | |||

=== ''' Anwendungsbeispiele ''' === | === ''' Anwendungsbeispiele ''' === | ||

| − | Bei der Verbindung räumlich naher Geräte kann InfiniBand jedoch seine Stärken ausspielen. Abseits der Supercomputer-Welt stellen daher applikationsspezifische Serverkoppelungen, Virtualisierungsplattformen, Storagelösungen sowie Backupanbindungen typische Anwendungsszenarien für InfiniBand dar. Gerade im Storagebereich lassen sich so nicht nur Performanceverbesserungen erzielen | + | Bei der Verbindung räumlich naher Geräte kann InfiniBand jedoch seine Stärken ausspielen. Abseits der Supercomputer-Welt stellen daher applikationsspezifische Serverkoppelungen, Virtualisierungsplattformen, Storagelösungen sowie Backupanbindungen typische Anwendungsszenarien für InfiniBand dar. Gerade im Storagebereich lassen sich so nicht nur Performanceverbesserungen erzielen sondern im Vergleich zu den proprietären Lizenzmodellen der Major Brands oft auch massive Preisvorteile. Entscheidend dafür ist der Einsatz von Software Defined Storage Lösungen, mit denen der Anwender unabhängig wird von einzelnen Herstellern, während InfiniBand die notwendige breitbandige Verbindung zwischen den eingesetzten Stan-dard-Komponenten bereitstellt. |

| + | |||

=== ''' Ein- und Umstieg ''' === | === ''' Ein- und Umstieg ''' === | ||

| − | Die Entscheidung für oder gegen InfiniBand ist nicht schwarz-weiß. IB-Komponenten koexistieren, wie be-reits erwähnt, ohne weiteres mit herkömmlichen Netzwerktechniken und lassen sich leicht integrieren. Daher sollte eine IT-Organisation im Bedarfsfalle die Umstellung Schritt für Schritt durchführten. Gerade zu Beginn sollten, wenn möglich, zuerst zusätzliche bzw. ergänzende Anwendungen mit IB realisiert werden, um das notwendige Know-How bei den Administratoren aufzubauen. Die Umstellung der Bestandssysteme, v.a. der geschäftskritischen Anwendungen, sollte erst danach erfolgen. Alle Schritte sollten ggf. durch externen Ex-pertenrat begleitet und abgesichert werden. Dadurch lassen sich Risiken für den IT-Betrieb minimieren und neue Strukturen von vorneherein optimal gestalten. | + | Die Entscheidung für oder gegen InfiniBand ist nicht schwarz-weiß. IB-Komponenten koexistieren, wie be-reits erwähnt, ohne weiteres mit herkömmlichen Netzwerktechniken und lassen sich leicht integrieren. Daher sollte eine IT-Organisation im Bedarfsfalle die Umstellung Schritt für Schritt durchführten. Gerade zu Beginn sollten, wenn möglich, zuerst zusätzliche bzw. ergänzende Anwendungen mit IB realisiert werden, um das notwendige Know-How bei den Administratoren aufzubauen. Die Umstellung der Bestandssysteme, v.a. der geschäftskritischen Anwendungen, sollte erst danach erfolgen. Alle Schritte sollten ggf. durch externen Ex-pertenrat begleitet und abgesichert werden. Dadurch lassen sich Risiken für den IT-Betrieb minimieren und neue Strukturen von vorneherein optimal gestalten. |

| + | |||

=== ''' Fazit ''' === | === ''' Fazit ''' === | ||

| − | Mit seinen technischen Eigenschaften stellt sich InfiniBand als die derzeit beste Option für die Serververnet-zung dar und ist aufgrund des massiven Preisverfalls auch für mittelständische Unternehmen erschwinglich. Ähnlich leistungsfähige Strukturen werden von den bekannten Herstellern meist nur als proprietäre Lösungen zu ungleich höheren Kosten angeboten. Während 100GbE und 32Gb FC noch in der Phase der Ankün-digungen und Marktvorbereitung stecken, ist InfiniBand ausgreift, stabil und verfügbar. Bereits seit Jahren nicht nur im High Performance Computing Bereich etabliert, garantieren Leistungsfähigkeit und Skalierbarkeit zusammen mit Offenheit, Herstellerunabhängigkeit und Interoperabilität des Standards Investitionssicherheit für Anwender, die an die Grenzen der herkömmlichen Technologien stoßen. Unternehmen sollten den Ein- und Umstieg zu InfiniBand schrittweise vollziehen, unter Einbeziehung des notwendigen Expertenwissens. | + | Mit seinen technischen Eigenschaften stellt sich InfiniBand als die derzeit beste Option für die Serververnet-zung dar und ist aufgrund des massiven Preisverfalls auch für mittelständische Unternehmen erschwinglich. Ähnlich leistungsfähige Strukturen werden von den bekannten Herstellern meist nur als proprietäre Lösungen zu ungleich höheren Kosten angeboten. Während 100GbE und 32Gb FC noch in der Phase der Ankün-digungen und Marktvorbereitung stecken, ist InfiniBand ausgreift, stabil und verfügbar. Bereits seit Jahren nicht nur im High Performance Computing Bereich etabliert, garantieren Leistungsfähigkeit und Skalierbarkeit zusammen mit Offenheit, Herstellerunabhängigkeit und Interoperabilität des Standards Investitionssicherheit für Anwender, die an die Grenzen der herkömmlichen Technologien stoßen. Unternehmen sollten den Ein- und Umstieg zu InfiniBand schrittweise vollziehen, unter Einbeziehung des notwendigen Expertenwissens. |

| − | |||

| − | |||

| − | |||

| − | |||

| + | === ''' Weitere Informationen ''' === | ||

| + | Weitere Informationen zu Netzwerkstrukturen finden Sie auf [https://www.max-it.de/techcorner/Netzwerkstrukturen-mit-InfiniBand www.max-it.de/maxCentral]/<br /> | ||

| + | <br /> | ||

| − | Wenn Sie Fragen oder Anmerkungen zu diesem Artikel haben, wenden Sie sich bitte an uns: mailto:techcorner@max-it.de.<br /> | + | === '''Kontakt''' === |

| + | Wenn Sie Fragen oder Anmerkungen zu diesem Artikel haben, wenden Sie sich bitte an uns:<br /> | ||

| + | [http://mailto:techcorner@max-it.de techcorner@max-it.de].<br /> | ||

| − | Über m.a.x. Informationstechnologie AG: <br /> | + | '''Über m.a.x. Informationstechnologie AG:''' <br /> |

| − | Als etabliertes Münchner Systemhaus zeichnen wir uns seit 1989 als verlässlicher IT-Partner mittelständischer und großer Unternehmen aus. Unser Portfolio reicht von IT- Services über individuelle Softwareentwicklung bis hin zur ERP-Beratung.<br /> | + | Als etabliertes Münchner Systemhaus zeichnen wir uns seit 1989 als verlässlicher IT-Partner mittelständischer und<br /> |

| + | großer Unternehmen aus. Unser Portfolio reicht von IT- Services über individuelle Softwareentwicklung bis hin zur ERP-Beratung.<br /> | ||

<br /> | <br /> | ||

| + | |||

| + | === ''' Tags ''' === | ||

| + | InfiniBand, Netzwerkstrukturen, High Performance Computing, Busstruktur, Netzwerkanwendungen,<br /> | ||

| + | applikationsspezifische Serverkoppelungen, Virtualisierungsplattform, Storagelösungen, Backupanbindungen | ||

| + | [[Kategorie: Netzwerk-Hardware]] | ||

Aktuelle Version vom 13. Mai 2020, 13:38 Uhr

Inhaltsverzeichnis

Zukunftssicher und mittelstandstauglich

Die Entwicklung der Basistechnologien und Übertragungsraten im Netzwerk- und Storagebereich ist in den letzten Jahren weit hinter dem Wachstum von Datenvolumen und Rechenkapazitäten in allen Anwendungsszenarien zurückgeblieben. Umso dringlicher wird die Suche nach zukunftsfähigen Al-ternativen auch im Mittelstand. InfiniBand verspricht, dafür die Lösung zu sein.

Welcher IT-Verantwortliche hätte sich das nicht auch schon gewünscht? Eine neue, stabile Technologie für den Serverpark, mit der die Übertragung großer Datenmengen nicht zur Geduldsprobe ausartet und die gleichzeitig weder das Budget noch die beherrschbare Komplexität sprengt. Noch weitgehend unbemerkt von der durchschnittlichen IT-Organisation hat sich in jüngster Zeit die InfiniBand-Technologie (IB) zu einer Lösung dieser Fragen gemausert. Sie verspricht, alle gewünschten Eigenschaften in sich zu vereinen, bis auf eine: Sie ist nicht neu. Das muss aber kein Nachteil sein.

Historie

Tatsächlich wurde der erste InfiniBand-Standard bereits im Jahr 2000 verabschiedet von der InfiniBand Trade Association (ITBA, ein Zusammenschluss von Compaq, Dell, Hewlett-Packard, IBM, Intel, Microsoft und Sun). Er war damals gedacht als Nachfolgetechnologie für den PCI Bus. Nachdem sich aber im Segment der Arbeitsstationen und Enterprise-Server stattdessen der PCI Express als Bus-System durchgesetzt hat, wurde InfiniBand immer mehr eine Verbindungstechnologie in der Domäne von Supercomputern und High-Performance-Anwendungen. Im Jahr 2014 basierten 45% der in der TOP500 gelisteten Supercomputer auf InfiniBand. Das zeigt, dass InfiniBand eine höchst ausgereifte, stabile und skalierbare Technologie ist, die jedoch lange Zeit zu teuer für den Einsatz in normalen Unternehmen war. Dies hat sich zuletzt deutlich ver-ändert:

Aufgrund technologischer Innovationen und der Suche nach neuen Zielmärkten sind die Preise für InfiniBand-Komponenten in den letzten Jahren auf ein Niveau gesunken, das sich nicht mehr von dem der Konkurrenztechnologien wie 10 GBit Ethernet oder Fibre Channel unterscheidet.

Technologie

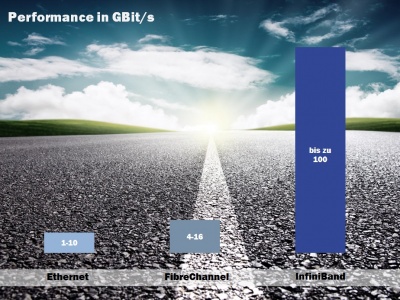

Obwohl ähnlich im Preisgefüge besitzt die Technologie von InfiniBand doch im Kern eine völlig andere Archi-tektur. Es handelt sich nicht um eine Netzwerk- sondern um eine Busstruktur. Man kann sich InfiniBand als eine „Verlängerung“ des serverinternen PCIe Busses vorstellen. Damit einher gehen einige Merkmale, die wesentlich für das Performanceversprechen dieses Standards sind: Die Übertragungsrate beträgt derzeit bis zu 100 GBit/s je Port bei gleichzeitig extrem niedriger Latenz. Für höhere Performanceanforderungen können mehrere physikalische Ports logisch gekoppelt werden. Als etablierte, nicht-experimentelle Technologie steht InfiniBand derzeit 10 GBit Ethernet bzw. 8 bis 16 GBit Fibre Channel gegenüber. Bei Storage-Anwendungen überträgt IB die Daten per RDMA (Remote Direct Memory Access). Dieses Feature erlaubt es Anwendungen, Daten direkt in den Hauptspeicher des Zielsystems zu schreiben, ohne Umweg über einen Netzwerkprotokoll-Stack. Das entlastet die CPU und vermeidet unnötige und zeitintensive Kopiervorgänge. Dieselbe Systematik ist mit InfiniBand auch für paketorientierte Netzwerkanwendungen verfügbar und wird RoCE genannt (RDMA over Converged Ethernet). Gleichzeitig gliedert sich InfiniBand nahtlos in bestehende IT-Landschaften ein, denn den Anwendungen zeigt es sich in der tatsächlichen Nutzung je nach Konfiguration als Netz- oder Datenverbindung. Diese Einstellung ist durch den Administrator festlegbar und hängt nicht von der eingesetzten IB Hardware ab. Anders ausgedrückt: Mit ein und derselben InfiniBand-Hardware lassen sich flexibel mehrere parallel nutzbare Ethernet- und blockbasierte Verbindungen (SRP/iSER) mit defi-nierbaren Bandbreiten realisieren. Die Einrichtung der IB-Komponenten ist kein Hexenwerk, sollte aber in Hinsicht auf die gewünschte Gesamtstruktur in Produktivumgebungen nur von Experten mit InfiniBand-Erfahrung durchgeführt werden. V.a. in heterogenen Systemlandschaften mit gemischten Technologien und unterschiedlichen Betriebssystemen gibt es bei der Umsetzung diverse Fallstricke, die erkannt und umgan-gen werden wollen. Im laufenden Betrieb unterstützt InfiniBand den Administrator dann durch seine umfang-reichen Monitoring-Fähigkeiten, die deutlich über das von der Konkurrenz Gewohnte hinausgehen. Spätes-tens hier jedoch stößt der Einsteiger an seine Grenzen, denn Konfiguration und treffsichere Interpretation des InfiniBand-Monitorings erfordern einiges an Detail-Know-How.

InfiniBand bietet überlegene Bandbreiten für die Vernetzung von Servern und Rechenzentren. Die Preise der drei Technologien bewegen sich auf vergleichbarem Niveau.

Komponenten und Anbieter

InfiniBand stellt den derzeit einzigen nicht-proprietären offenen Hochgeschwindigkeitsstandard dar. Eine InfiniBand-Infrastruktur wird aus denselben grundlegenden Komponenten aufgebaut wie herkömmliche Net-ze: IB-Host-Channel-Adapter (HCAs) in den beteiligten Servern, dazwischen IB-Kabel aus Kupfer oder Glas-faser und im Allgemeinen auch IB-Switches bzw. Router. Preise beginnen bei unter 500,- Euro für HCAs, unter 3.500,- Euro für einen 12-Port Managed Switch und unter 100,- Euro für 5 Meter Kupferkabel. Viele IB-Switches bieten eine Besonderheit:

Damit die schöne neue InfiniBand-Welt keine Insel bleibt, besitzen sie die Möglichkeit über ein Splitter-Kabel einen 40G-Port in einen oder mehrere 10G-Ports für den Übergang ins restliche Unternehmensnetzwerk bereitzustellen. Mit einem 12-Port Switch sind so 48x10G-Ports realisierbar. Trotz gesunkener Preise wird kaum eine Organisation mehr als den Serverraum mit InfiniBand ausstatten wollen, obwohl das technisch in einer geswitchten Infrastruktur mit Kabellängen von bis zu über hundert Metern durchaus möglich wäre. Zum Betrieb der HCAs in den Servern bedarf es passender Treiber je Betriebssystem. Aufgrund der Offenheit und Unabhängigkeit des Standards sind diese für alle gängigen Systeme verfügbar, u.a. für Windows Server und Client Versionen, alle großen Linux Distributionen wie Red Hat und SUSE sowie für die Virtualisierer VMware ESXi, Microsoft Hyper-V und Citrix/Xen. Der dominieren-de Hersteller von IB-Baugruppen ist die Firma Mellanox, die auch alle Varianten von fertigen Komponenten anbietet. Komponenten stellen aber auch diverse andere Integratoren her, wie beispielsweise Intel/QLogic oder Oracle/Sun. Auch weitere Major Brands setzen mit ihren Produkten auf InfiniBand, etwa Cisco bei Ser-ver¬switches der 3000er und 7000er Serie. Andere Anbieter tun innerhalb ihrer Black-Boxen dasselbe, aller-dings ohne dabei InfiniBand beim Namen zu nennen. Trotz der Offenheit des Standards ist aber nicht zu leugnen, dass die Schar der Anbieter von InfiniBand-Komponenten derzeit noch überschaubar ist. Das liegt an der Abgeschlossenheit des High Performance Computing Bereichs, in dem sich InfiniBand bis vor weni-gen Jahren ausschließlich entwickelt hat. Es steht zu erwarten, dass mit den gesunkenen Preisen und wachsender Verbreitung auch die Anbieter in absehbarer Zeit deutlich zahlreicher werden.

InfiniBand-Komponenten: Switch, Host-Channel-Adapter und Kabel

Vorteile und Einschränkungen

So ergeben sich im Vergleich zu herkömmlichen Verkabelungslösungen im Serverbereich eine ganze Reihe von Vorteilen:

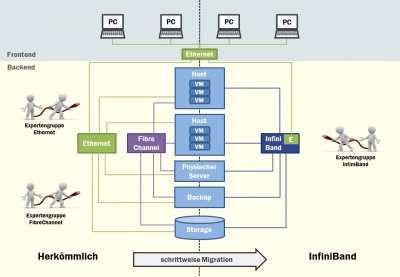

Neben deutlich höheren und skalierbaren Übertragungsbandbreiten bei gleichzeitig geringerer Latenz und Hostbelastung stellt InfiniBand durch die hohe Produktreife im Betrieb erstklassige Zuverlässig-keit und Wartbarkeit sicher. Die Möglichkeit, InfiniBand-Verbindungen bedarfsgerecht sowohl als Netzwerk-wie auch als Datenverbindung zu konfigurieren, birgt das Potential, sowohl Ethernet als auch Fibre Channel bzw. iSCSI bei der Serververnetzung nicht nur zu ergänzen, sondern vollständig abzulösen. Man spricht in diesem Zusammenhang von Netzwerkkonvergenz. Daraus wird in vielen Fällen nicht nur eine Leistungsstei-gerung resultieren, sondern gleichzeitig eine Komplexitätsreduktion der notwendigen Netzstrukturen. Zum einen sinkt aufgrund der Bandbreitenvorteile tendenziell die Anzahl der notwendigen physikalischen Verbin-dungen, zum anderen lassen sich alle Anwendungsfälle mit derselben Technologie abdecken. Das führt dazu, dass auch die Kosten für Aufbau und Betrieb eines IB-Netzes häufig niedriger ausfallen als bei den Konkurrenztechnologien: Eine geringere Anzahl an technischen Komponenten, weniger stark diversifiziertes Fachwissen innerhalb der Betriebsgruppen und zu guter Letzt die Herstellerunabhängigkeit und Offenheit des Standards mit entsprechend konkurrenzfähigen Komponenten- und Lizenzmodellen machen dies möglich.

Wo so viel Licht ist, muss es naturgemäß auch Schatten geben. So ist InfiniBand zum heutigen Stand klar auf die Vernetzung innerhalb von Serverräumen bzw. Rechenzentren ausgelegt. Gebäudeübergreifende (Campus) Netzwerke sind von 1-80km möglich. Für die Vernetzung hin zu den Clients ist Ethernet nach wie vor unersetzlich. Auch wenn der Übergang von den IB-Komponenten leicht gemacht wird, ist doch auch in Zukunft entsprechendes Ethernet-Equipment und Know-How für die IT-Organisationen unerlässlich. Und auch bei der Überbrückung weiter Entfernungen ist InfiniBand nicht immer erste Wahl:

Über Glasfaser lassen sich derzeit WAN-Strecken mit bis zu 1600 Kilometer überbrücken, die Reichweite von Ethernet bleibt jedoch unübertroffen.

Netzwerkkonvergenz: Da InfiniBand sowohl als Ethernet als auch als Fibre Channel Verbindungen konfiguriert werden können, lässt es sich leicht in bestehende Infrastrukturen integrieren und bietet die Möglichkeit, die alten Standards schrittweise vollständig abzulösen.

Anwendungsbeispiele

Bei der Verbindung räumlich naher Geräte kann InfiniBand jedoch seine Stärken ausspielen. Abseits der Supercomputer-Welt stellen daher applikationsspezifische Serverkoppelungen, Virtualisierungsplattformen, Storagelösungen sowie Backupanbindungen typische Anwendungsszenarien für InfiniBand dar. Gerade im Storagebereich lassen sich so nicht nur Performanceverbesserungen erzielen sondern im Vergleich zu den proprietären Lizenzmodellen der Major Brands oft auch massive Preisvorteile. Entscheidend dafür ist der Einsatz von Software Defined Storage Lösungen, mit denen der Anwender unabhängig wird von einzelnen Herstellern, während InfiniBand die notwendige breitbandige Verbindung zwischen den eingesetzten Stan-dard-Komponenten bereitstellt.

Ein- und Umstieg

Die Entscheidung für oder gegen InfiniBand ist nicht schwarz-weiß. IB-Komponenten koexistieren, wie be-reits erwähnt, ohne weiteres mit herkömmlichen Netzwerktechniken und lassen sich leicht integrieren. Daher sollte eine IT-Organisation im Bedarfsfalle die Umstellung Schritt für Schritt durchführten. Gerade zu Beginn sollten, wenn möglich, zuerst zusätzliche bzw. ergänzende Anwendungen mit IB realisiert werden, um das notwendige Know-How bei den Administratoren aufzubauen. Die Umstellung der Bestandssysteme, v.a. der geschäftskritischen Anwendungen, sollte erst danach erfolgen. Alle Schritte sollten ggf. durch externen Ex-pertenrat begleitet und abgesichert werden. Dadurch lassen sich Risiken für den IT-Betrieb minimieren und neue Strukturen von vorneherein optimal gestalten.

Fazit

Mit seinen technischen Eigenschaften stellt sich InfiniBand als die derzeit beste Option für die Serververnet-zung dar und ist aufgrund des massiven Preisverfalls auch für mittelständische Unternehmen erschwinglich. Ähnlich leistungsfähige Strukturen werden von den bekannten Herstellern meist nur als proprietäre Lösungen zu ungleich höheren Kosten angeboten. Während 100GbE und 32Gb FC noch in der Phase der Ankün-digungen und Marktvorbereitung stecken, ist InfiniBand ausgreift, stabil und verfügbar. Bereits seit Jahren nicht nur im High Performance Computing Bereich etabliert, garantieren Leistungsfähigkeit und Skalierbarkeit zusammen mit Offenheit, Herstellerunabhängigkeit und Interoperabilität des Standards Investitionssicherheit für Anwender, die an die Grenzen der herkömmlichen Technologien stoßen. Unternehmen sollten den Ein- und Umstieg zu InfiniBand schrittweise vollziehen, unter Einbeziehung des notwendigen Expertenwissens.

Weitere Informationen

Weitere Informationen zu Netzwerkstrukturen finden Sie auf www.max-it.de/maxCentral/

Kontakt

Wenn Sie Fragen oder Anmerkungen zu diesem Artikel haben, wenden Sie sich bitte an uns:

techcorner@max-it.de.

Über m.a.x. Informationstechnologie AG:

Als etabliertes Münchner Systemhaus zeichnen wir uns seit 1989 als verlässlicher IT-Partner mittelständischer und

großer Unternehmen aus. Unser Portfolio reicht von IT- Services über individuelle Softwareentwicklung bis hin zur ERP-Beratung.

Tags

InfiniBand, Netzwerkstrukturen, High Performance Computing, Busstruktur, Netzwerkanwendungen,

applikationsspezifische Serverkoppelungen, Virtualisierungsplattform, Storagelösungen, Backupanbindungen